글 | 김복희 (고려대학교)

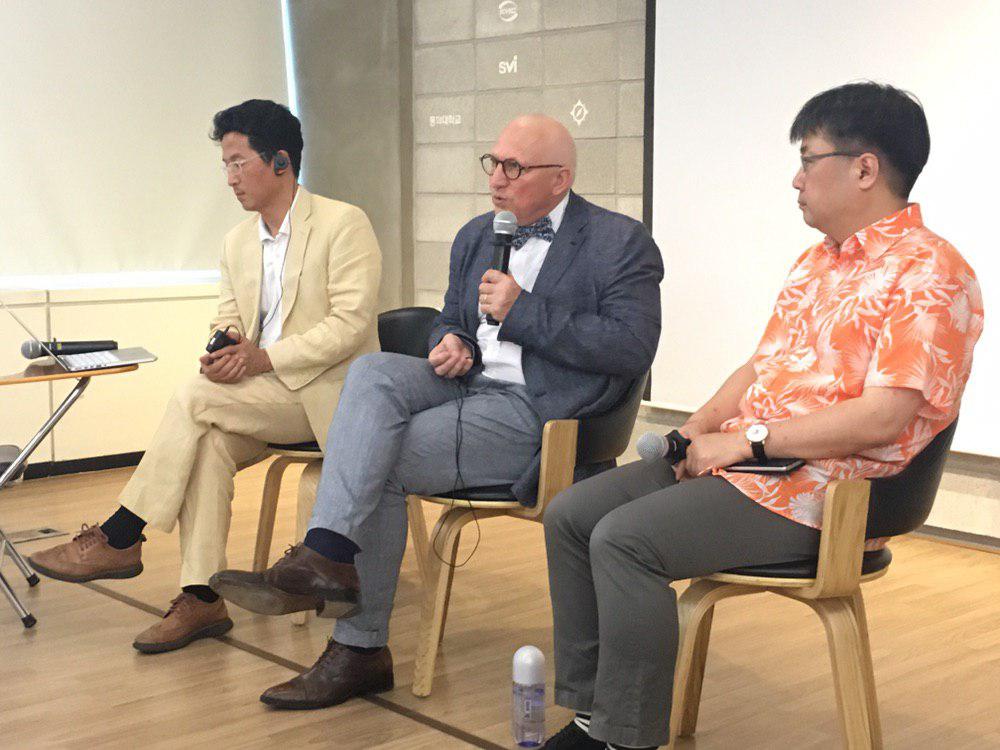

인공지능 편향과 윤리적 과제>라는 주제로 지난 6월 24일 오픈넷과 주한 프랑스문화원 공동 주최로 스타트업 얼라이언스 엔스페이스(서울 강남구 삼성동)에서 강연 및 대담이 열렸다. 인지과학자이자 철학자인 장 가브리엘 가나시아(Jean-Gabriel Ganascia) 파리6대학 정보과학 교수는 “공정성, 정의, 인공지능 및 의사결정”(Fairness, Justice, Artificial Intelligence and Decision Making)을 중심으로 총 6가지의 질문을 던지며 기조강연을 진행했다. 그 질문의 내용은 “1.인공지능이란 무엇인가 2. 의사결정에 있어 자율성과 자동성의 차이는 무엇인가 3.공정성과 정의는 무엇인가 4. 어떻게 하면 윤리적 원칙을 지닌 공정한 주체를 만들 수 있겠는가 5. 불공정한 주체의 가능성을 기반으로, 어떻게 공정한 주체를 만들 수 있겠는가 6. 윤리적 트릴레마를 어떻게 해결할 수 있겠는가.”였다.

먼저 가나시아 교수는 인공지능이 진정한 주체라고 말할 수 있는가 묻고, 인공지능이 현 단계에서는 실행의 명령을 입력하지 않으면 스스로 무엇인가를 실행하지는 않기 때문에 인공지능을 제한적인 주체로서 인지해야 함을 강조했다. 흔히 자율주행 자동차 혹은 자율형 무기가 있음을 예로 들어 사람들은 인공지능이 주체적으로 판단을 내리고 실행을 한다고 생각한다. 그러나 가나시아 교수는 자율성과 자동성의 차이를 들어, 현재의 인공지능은 외부의 명령어에 의해 움직이므로 조건부 자율성으로 그 특성을 논의해야 한다고 주장했다. 특히 그 인공지능을 개발한 개발 주체―기업이나 군대, 국가―가 진정으로 원하는 것은 복종하는 인공지능이지 스스로 판단을 내리는 인공지능이 아니기 때문이라는 설명도 덧붙였다.

이어서 인공지능은 공정하며 정의로울 것이라는 가설에 대해서는 인간사회에서도 공정성과 정의에 대한 기본적인 합의가 어려운 상황임을 전제한 후, 인공지능이 그것을 획득할 수 있으리라 보는 다소 낙관적인 전망에 대해서도 유보적인 견해를 제시했다. 테이(tay)라는 마이크로소프트 사에서 제작한 챗봇이 빠르게 각종 차별적 데이터를 학습하여, 성차별 인종차별적인 언급을 서슴지 않았던 사례를 들며 인공지능에게 주어진 학습 환경이 어떤가에 따라 인공지능은 공정하지 않을 수 있으며 정의롭지 않을 수 있음을 주지했다.

가나시아 교수는 그렇다면, ‘인공지능을 공정한 주체로 만들 수 있겠는가’ 하는 질문을 던졌다. 여기서 앞서 언급했던 자율성이 문제가 되는데 인공지능이 실제로 스스로 명령을 수행하는 논리적인 혹은 비논리적인 윤리판단, 가치판단을 내릴 수 있는 단계에 아직 이르지 않았기 때문에 계속 논의해 봐야 할 문제라고 이야기하였다. 또한 인공지능이 개개인의 민감하고 내밀한 개인정보 전체에 접근할 수 있는 권한을 갖게 하는 문제에 대해서는 지속적인 논의가 필요하다고 강조했다. 현재의 단계에서 인공지능이 주체적으로 판단할 수 있는가 아닌가의 여부를 논의하기 이전에, 인공지능이 기계학습을 위해서 그 모든 정보에 접근할 수 있도록 한다는 것은 또다른 주체―기업이나 국가―가 인공지능을 악용할 가능성을 배제할 수 없기 때문이다.

또한 가나시아 교수는 현재 데이터에 기반하여, 기계가 인간보다 계산이나 진단을 빠르고 정확하게 내리는 상황을 무시할 수는 없기에 인간 대신 기계가 대부분의 결정을 내리고 인간은 기계에 종속될 것이라는 예측, 즉 현 인류는 기계학습을 기반으로 한 데이터의 시대에 돌입했다는 주장에 대해서 청중들은 어떻게 생각하는지 질문을 던졌다. 가나시아 교수는 기계가 인간보다 뛰어날 것이며, 인간이 기계에 종속될 거라는 주장, 인간은 필요가 없어지고 데이터와 데이터를 처리할 과학자만 필요성을 인정받게 될 거라는 전망에 대해서 의견을 달리한다고 본인의 답을 먼저 내놓았다. 사실, 데이터란 단순히 모아둔다고 해서 질적으로 우수한 정보가 되는 것이 아니기 때문이다. 데이터는 반드시 목적이 필요하며, 일정한 목적 하에 분류되고 이용되는 것임을 기억해야 하며, 목적을 설정하는 주체는 아직까지는 인간이라는 것이다.

결국 인공지능이 주체가 되도록 할 기계 학습을 위해서는, 데이터를 제공할 인간의 윤리 문제를 재논의할 수밖에 없음을 강조했다. 인간이 윤리적인 원칙을 세우는 데에는 Diversity(inclusion)다양성, Non-discrimination비차별, Fairness(justice)공정성의 세 원칙이 서로 충돌하고 있으므로 끝없는 공론화를 통해서 이를 합의해 나가는 지난한 과정이 필요할 것임을 주지했다. 가나시아 교수는 ‘윤리적인 기계에서 윤리를 위한 기계로From machine ethics to ethics machine’의 발상을 주장했는데 인간은 윤리적 판단을 기계에게 맡기려는 생각보다는, 보다 발전할 기계를 통해 숙고하는 것에 도움을 받아 보다 윤리적인 주체로 거듭날 생각을 해야 할 것이라고 언급했다. 즉, 기계의 발달, 인공지능의 발달을 통해 보다 더 선한 주체로서 인간의 발달을 도모하자는 주장이다.

이어지는 토론에서 이상욱 한양대 철학과 교수는 기계학습을 통해 인공지능이 윤리를 학습할 수 없는 것인가 질문했고, 가나시아 교수는 기계학습을 통해 데이터를 모을 수는 있지만, 그 학습 위에 윤리적 원칙을 씌우는 것이지, 기계학습 자체로 윤리적 판단을 내릴 수 있을지에 대해서는 회의적이라고 밝혔다. 이어서 박경신 고려대 법학전문대학원 교수는 ‘인공지능이 윤리적 판단을 내릴 수 없다면, 결국 문제는 확실한 명령과 지시를 내릴 인간에게 있는 것이 아닌가’ 하는 질문을 던졌다. 보다 상위의 명령―나은 주체가 되어라, 윤리적 주체가 되어라 등―을 내릴 수 있어야 할 인간의 판단, 인간의 개입이 문제가 되는 것인가 하는 질문이었다. 가나시아 교수 역시 이에 동의하면서, 흔히들 머신러닝에 한계가 없다고 생각하지만, 데이터를 수집하고 분류하고 규범에 따라 틀 속에서 활용할 수 있도록 해야 하는데, 이때 전 인류적으로 완전히 합의될 수 있는 도덕률을 정할 수는 없다 하더라도 어느 정도는 모두가 동의할 수밖에 없는 보편적인 윤리의 선, 한계를 정할 수 있지 않는가 반문했다. 즉, 좋은 원칙을 새로이 세우려 하기 보다 이미 있는 원칙들 간에 합의를 도출해 낼 공론장의 역할이 중요할 것임을 강조했다.

이날의 강연은 기술의 발달로 인해 사람들이 보이는 확증편향은 원래 사람들이 내제하고 있었던 것이므로, 인공지능이나 기계 때문에 드러나는 것이 아니라는 것을 확인할 수 있는 자리였다. 인간의 다양한 비윤리적인 문제들은 인공지능의 발달로 새롭게 생겨난 문제라기보다, 결국 우리가 갖고 있던 문제가 증폭되는 것일 뿐이다. 따라서 인간으로서 우리가 할 일은 인공지능의 발달을 두려워하거나 배제할 것이 아니라, 발달한 기술을 이용하여 정책을 보완하고, 사회적 합의를 도출하려는 주체적 노력이다.